Amazon SageMaker StudioでAmazon SageMaker JumpStartの独自の基盤モデルを使用してください

Use Amazon SageMaker JumpStart's proprietary base model on Amazon SageMaker Studio.

Amazon SageMaker JumpStartは、機械学習(ML)のハブであり、MLの旅を加速するのに役立ちます。 SageMaker JumpStartを使用すると、公開されているプロプライエタリな基礎モデルと専用のAmazon SageMakerインスタンスに展開して、生成AIアプリケーションに使用できます。 SageMaker JumpStartを使用すると、ネットワークが分離された環境から基礎モデルを展開でき、モデルの提供者と顧客のトレーニングおよび推論データを共有しません。

この投稿では、AI21、Cohere、LightOnなどのモデルプロバイダーから専有モデルをAmazon SageMaker Studioから始める方法について説明します。 SageMaker Studioは、SageMakerエンタープライズデータサイエンティストのお客様が、次の生成AIアプリケーションのためにモデルを評価および構築するノートブック環境です。

SageMakerの基礎モデル

Foundationモデルは、数十億のパラメーターを含む大規模なMLモデルであり、テキストや画像データのテラバイトで事前にトレーニングされているため、記事の要約、テキスト、画像、またはビデオの生成など、幅広いタスクを実行できます。 Foundationモデルはトレーニング済みであるため、トレーニングおよびインフラストラクチャのコストを削減し、ユースケースに合わせたカスタマイズを可能にすることができます。

SageMaker JumpStartでは、2種類の基礎モデルを提供しています。

- A.I.はいつか医療の奇跡を起こすかもしれませんしかし今のところ、役立つのは書類作業です

- 3Dプリントされたセラミックはガスタービンの燃料効率を向上させる可能性がある

- ロボットのライバルを撃退した後、オスのハエは交尾においてより優れたパフォーマンスを発揮する

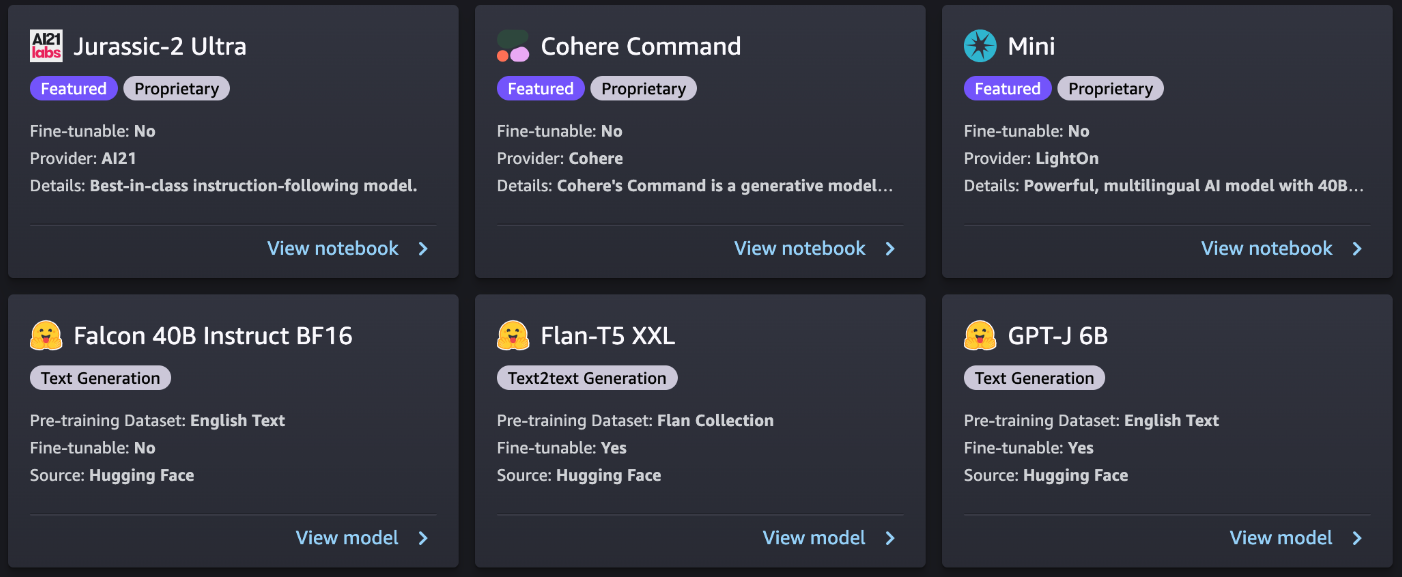

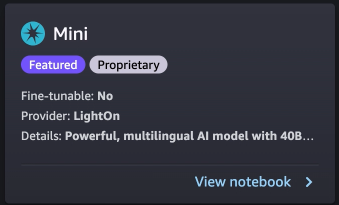

- プロプライエタリモデル–これらのモデルは、AI21のJurassic-2モデル、CohereのCohere Command、およびLightOnのMiniなどのプロプライエタリアルゴリズムとデータでトレーニングされたプロバイダーからのものです。重量やスクリプトなどのモデルアーティファクトを表示することはできませんが、推論のためにSageMakerインスタンスに展開できます。

- 公開モデル–これらは、Hugging FaceのStable Diffusion、Falcon、およびFLANなどの人気のあるモデルハブから公開されたアルゴリズムとデータでトレーニングされたものです。これらのモデルでは、ユーザーはモデルアーティファクトにアクセスし、推論のための展開の前に自分自身のデータでファインチューニングすることができます。

モデルを発見する

SageMaker JumpStartを介して、SageMaker Studio UIおよびSageMaker Python SDKからFoundationモデルにアクセスできます。 このセクションでは、SageMaker Studio UIでモデルを発見する方法について説明します。

SageMaker Studioは、MLのためのWebベースの統合開発環境(IDE)であり、MLモデルを構築、トレーニング、デバッグ、展開、およびモニターすることができます。 SageMaker Studioの開始方法とセットアップの詳細については、Amazon SageMaker Studioを参照してください。

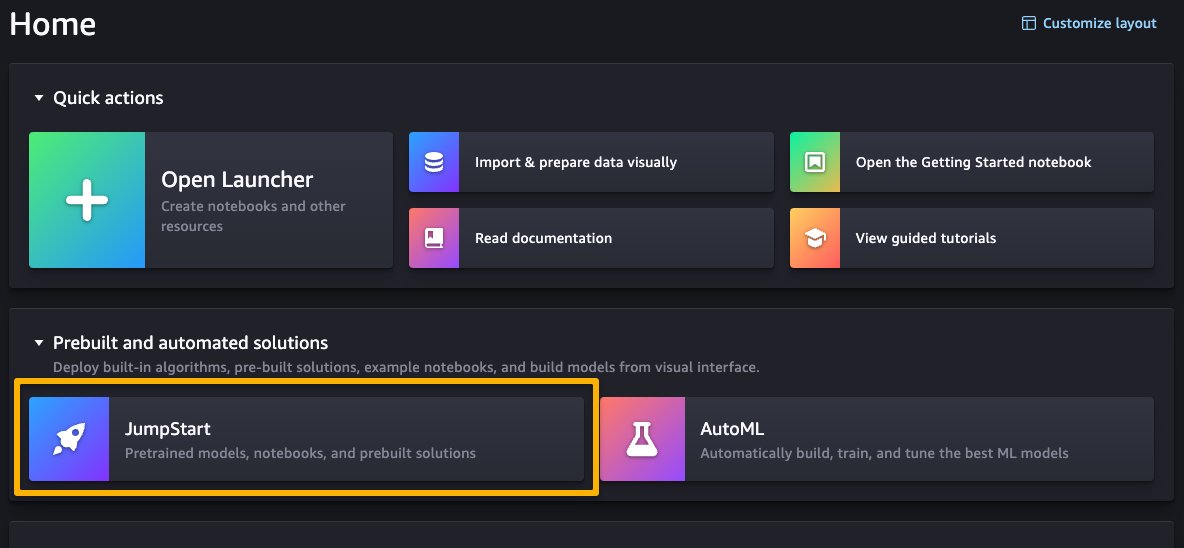

SageMaker Studio UIにアクセスしたら、Prebuilt and automated solutionsの下にあるSageMaker JumpStartにアクセスできます。

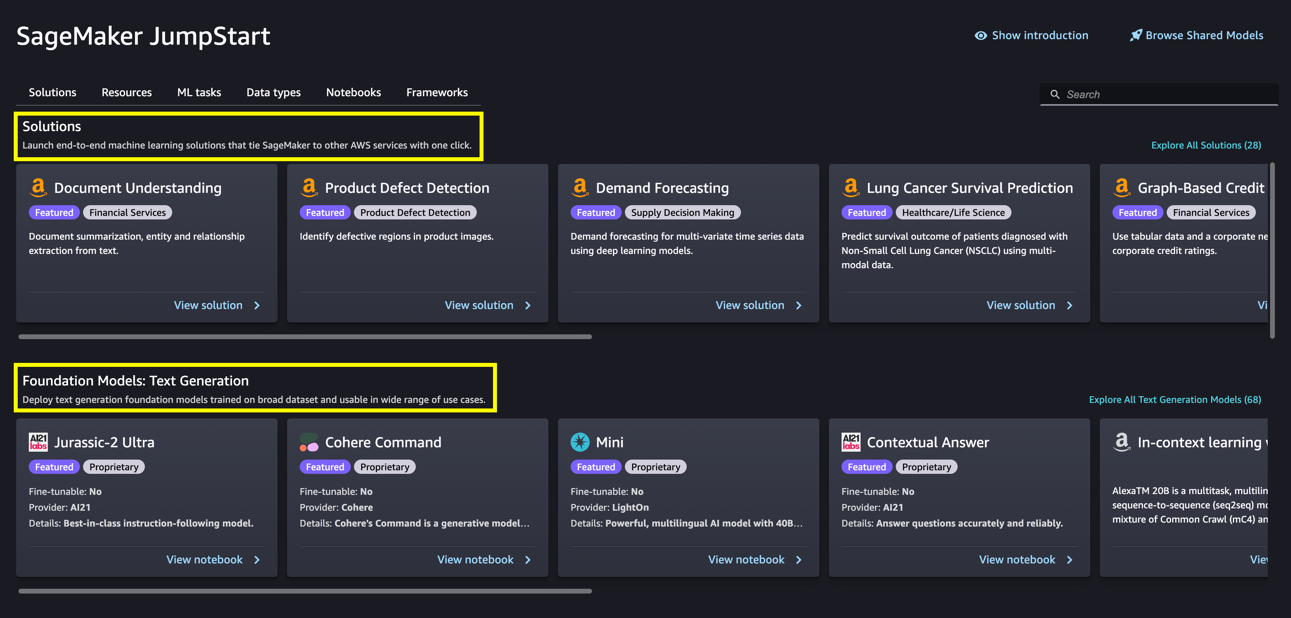

SageMaker JumpStartランディングページから、ソリューション、モデル、ノートブック、およびその他のリソースをブラウズできます。 次のスクリーンショットは、ソリューションと基礎モデルがリストされたランディングページの例を示しています。

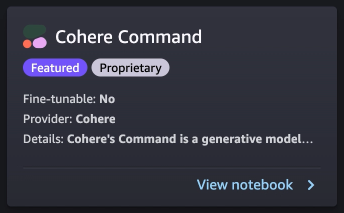

各モデルには、モデル名、ファインチューニング可能かどうか、プロバイダー名、およびモデルに関する短い説明が含まれるモデルカードがあります。 モデルカードを開いてモデルについて詳しく学び、トレーニングまたはデプロイを開始することもできます。

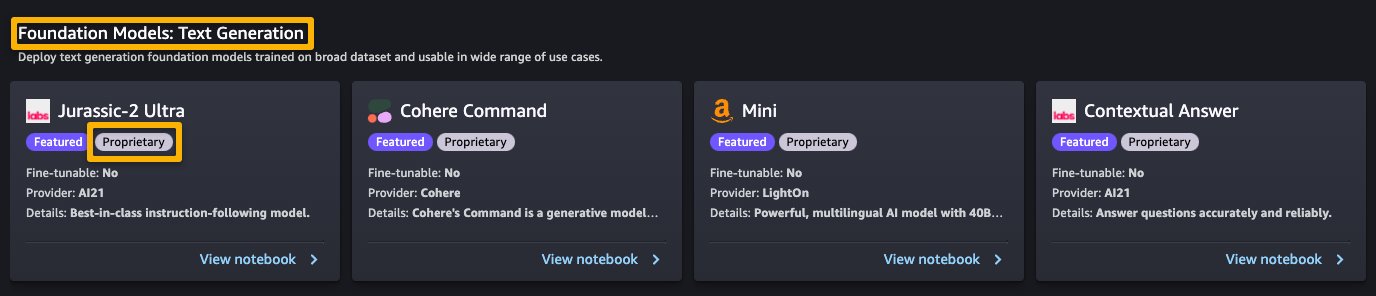

AWS Marketplaceでサブスクライブする

SageMaker JumpStartのプロプライエタリモデルは、AI21、Cohere、LightOnなどのモデルプロバイダーによって公開されています。 次のスクリーンショットに示すように、モデルカードの「プロプライエタリ」タグでプロプライエタリモデルを特定できます。

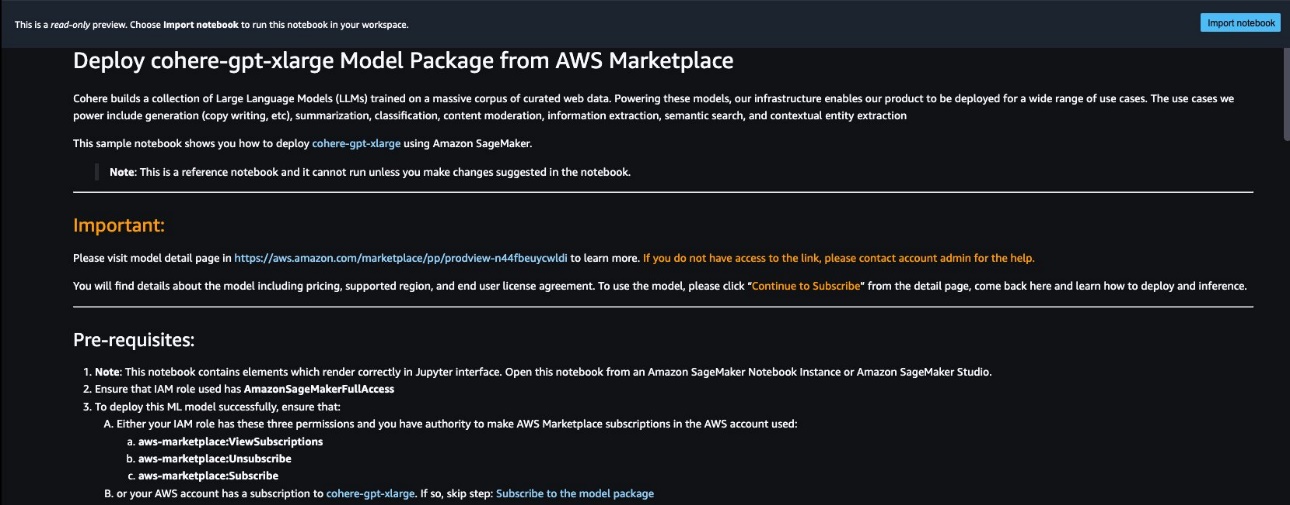

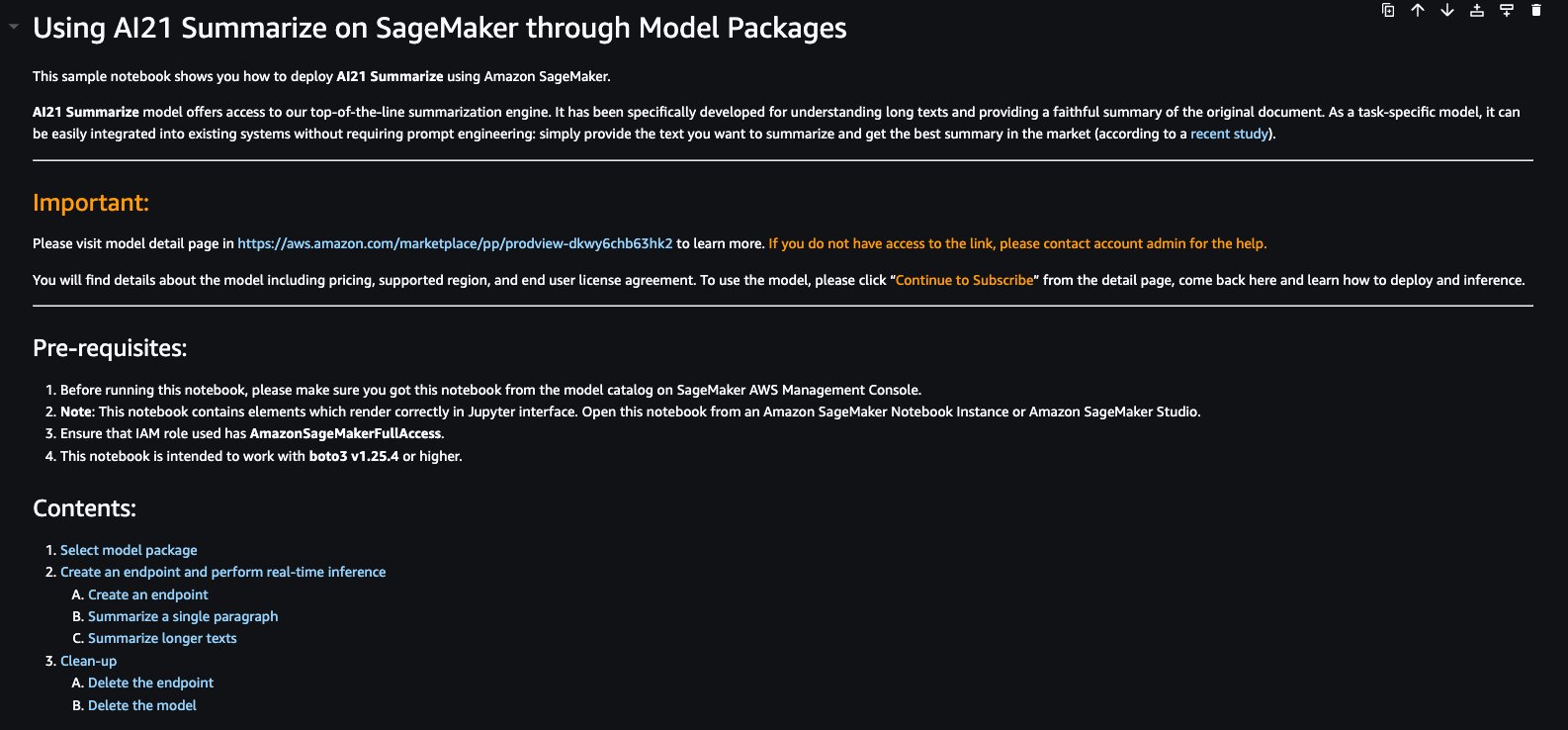

モデルカード上のView notebookを選択すると、以下のスクリーンショットに示すように、読み取り専用モードでノートブックを開くことができます。Prerequisitesやその他の使用手順に関する重要な情報を含むノートブックを読むことができます。

ノートブックのインポート後、コードを実行する前に適切なノートブック環境(イメージ、カーネル、インスタンスタイプなど)を選択する必要があります。また、選択したノートブックに従ってサブスクリプションと使用手順を守る必要があります。

プロプライエタリモデルを使用する前に、AWS Marketplaceからモデルに最初にサブスクライブする必要があります:

- AWS Marketplaceのモデルリストページを開きます。

URLは、ノートブックのImportantセクションに提供されています。または、SageMaker JumpStartサービスページからアクセスできます。リストページには、モデルに関する概要、価格、使用方法、サポート情報が表示されます。

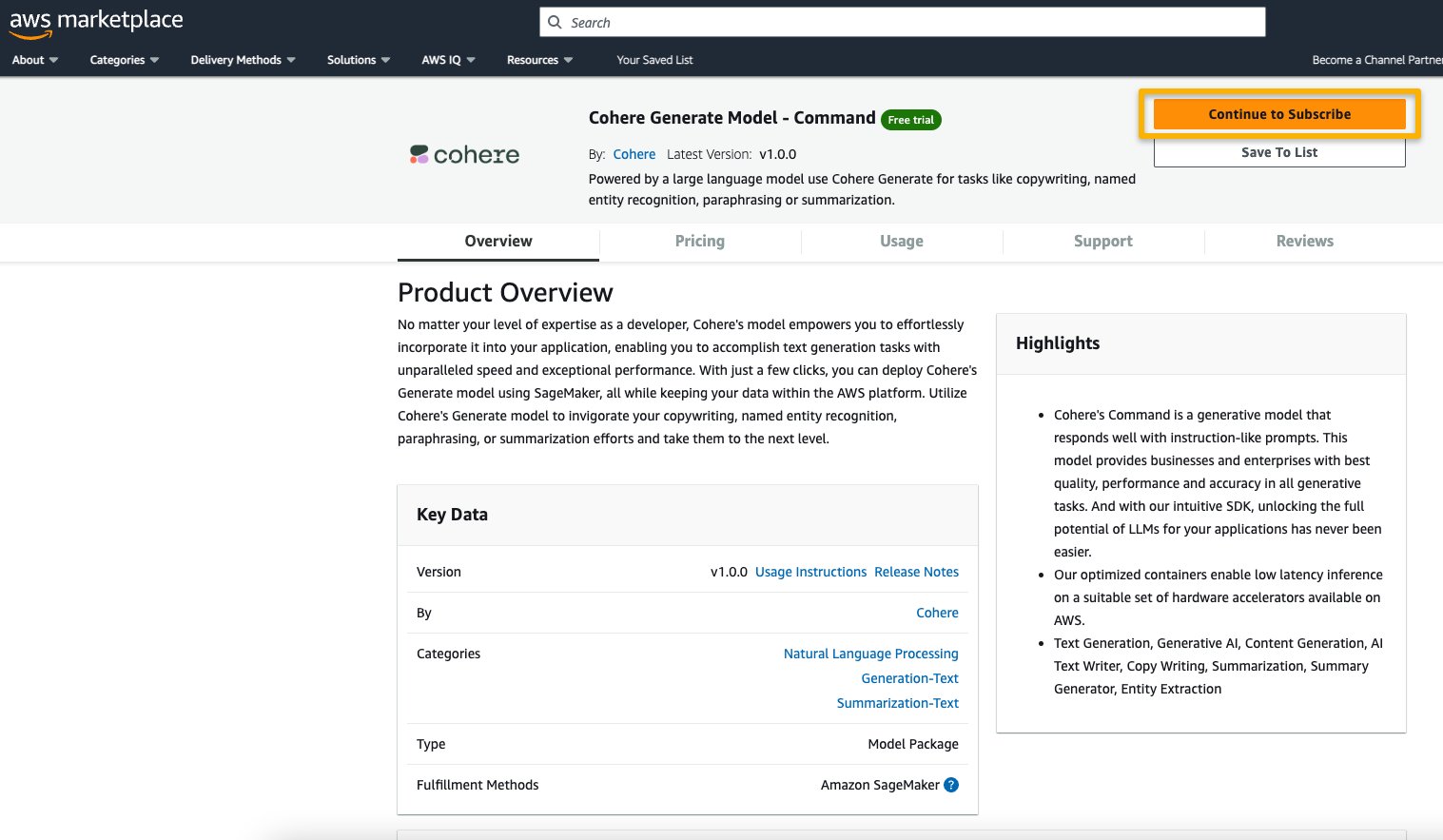

- AWS Marketplaceのリストで、Continue to subscribeを選択します。

モデルを表示またはサブスクライブするために必要な権限がない場合は、IT管理者または調達担当者に連絡して、モデルにサブスクライブしてもらう必要があります。多くの企業では、AWS Marketplaceのアクションを制御するために、AWS Marketplace Management Portalでそのような権限を制限する場合があります。

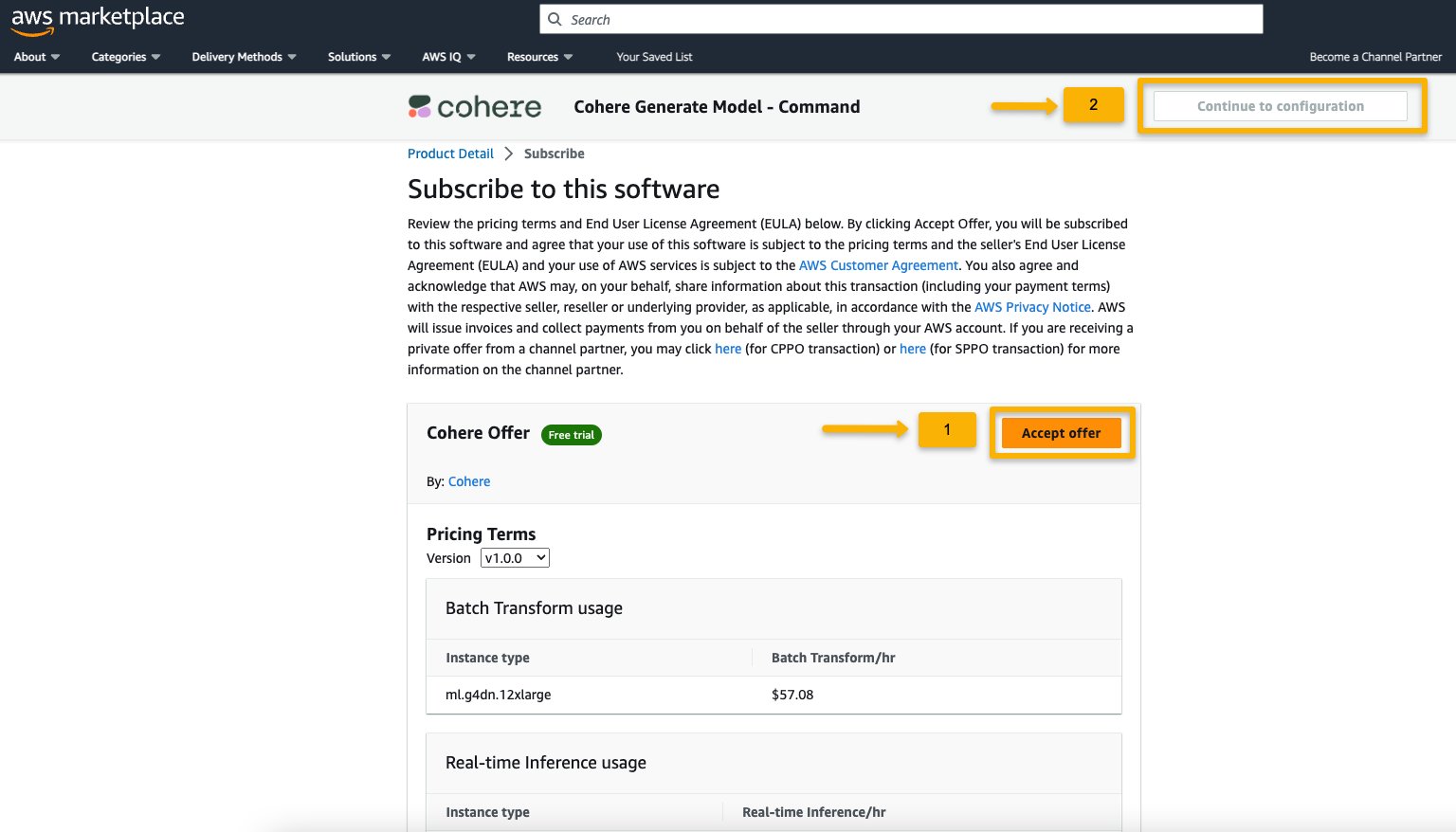

- Subscribe to this software pageで詳細を確認し、EULA、価格、サポート条件に同意する場合は、Accept offerを選択します。

質問や量の割引に関するリクエストがある場合は、モデルプロバイダーに直接サポートメールで連絡するか、AWSアカウントチームに連絡してください。

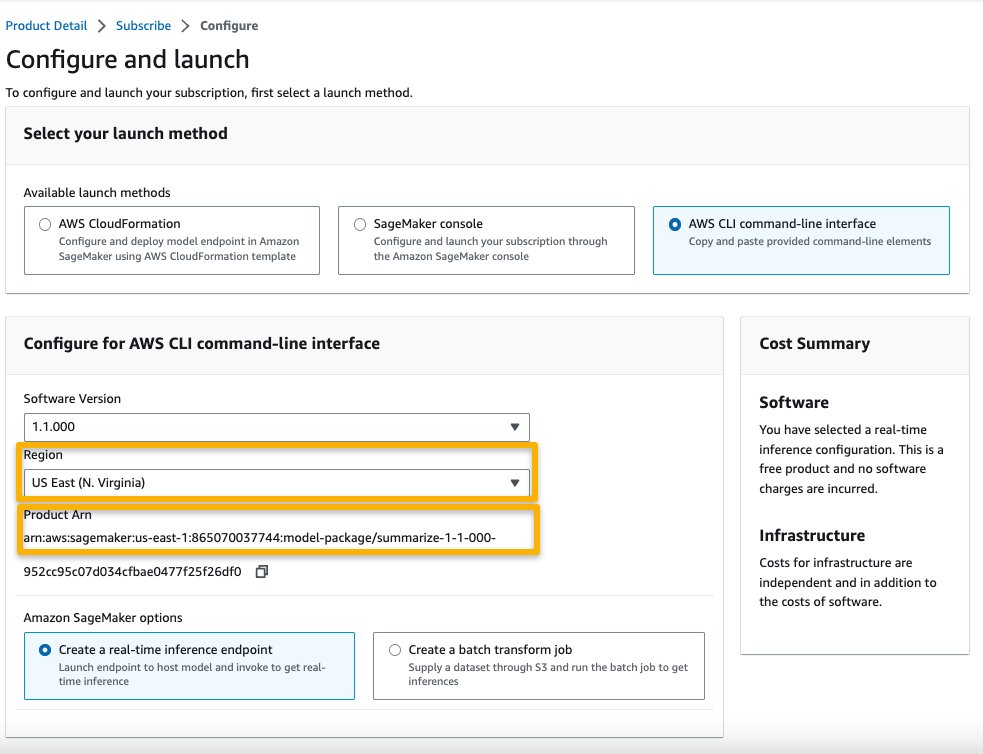

- Continue to configurationを選択して、リージョンを選択します。

製品ARNが表示されます。これは、Boto3を使用して展開可能なモデルを作成する際に指定する必要があるモデルパッケージARNです。

- リージョンに対応するARNをコピーし、ノートブックのセル指示に同じものを指定します。

サンプルのインファレンシングとサンプルのプロンプト

SageMaker StudioのSageMaker JumpStartで発見できるA21 Labs、Cohere、およびLightOnのサンプルファンデーションモデルのいくつかを見てみましょう。すべてのモデルには、AWS Marketplaceからのサブスクリプションや適切なIAMロールの権限、必要なboto3バージョンなどが必要です。モデルパッケージを選択し、リアルタイム推論のエンドポイントを作成し、クリーンアップする方法について説明します。

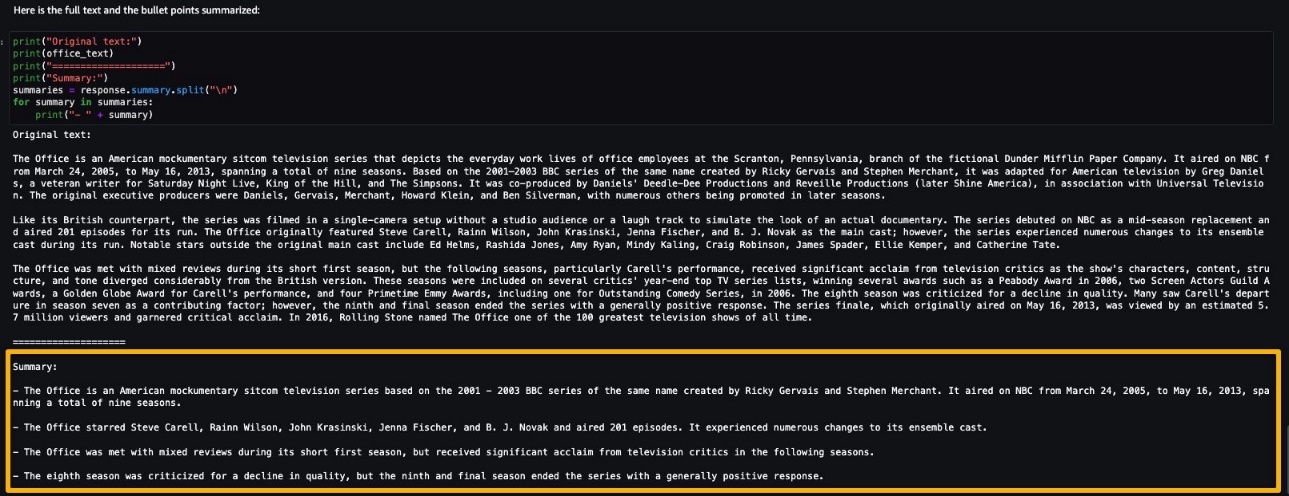

AI21 Summarize

A121 LabsによるSummarizeモデルは、長いテキストを短く、読みやすいバイトにまとめ、ソースとの事実の整合性を保ちます。このモデルは、テキストの本文に基づいて、主要なアイデアを捉える要約を生成するためにトレーニングされています。プロンプトは必要ありません。簡単に要約する必要があるテキストを入力するだけです。ソーステキストには、約10,000語または40ページに相当する最大50,000文字を含めることができます。

AI21 Summarizeモデルのサンプルノートブックには、従う必要がある重要な前提条件が記載されています。たとえば、モデルがAWS Marketplaceからサブスクライブされている、適切なIAMロールの権限がある、必要なboto3バージョンなどです。モデルパッケージを選択し、リアルタイム推論のエンドポイントを作成し、クリーンアップする方法について説明します。

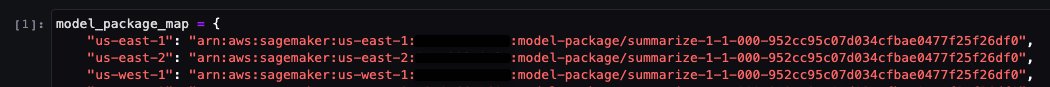

選択したモデルパッケージには、ARNをリージョンにマッピングする情報が含まれています。これは、AWS Marketplaceのサブスクリプションページでマーケットプレイスで評価および購読セクションで構成を続行するを選択し、対応する製品ARNを表示するリージョンを選択した後にキャプチャした情報です。

ノートブックにはすでにARNが事前に入力されている場合があります。

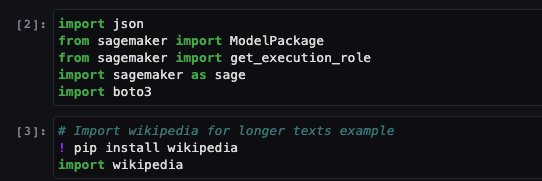

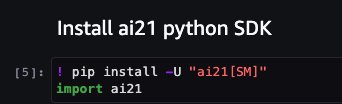

次に、このノートブックを実行するために必要ないくつかのライブラリをインポートし、Pythonでデータにアクセスして解析することを簡単にするPythonライブラリであるWikipediaをインストールします。ノートブックでは、後でWikipediaから長いテキストを要約する方法を示すためにこれを使用します。

ノートブックはまた、SageMaker API(deployおよびinvoke endpointなど)のラッパーであるai21 Python SDKをインストールします。

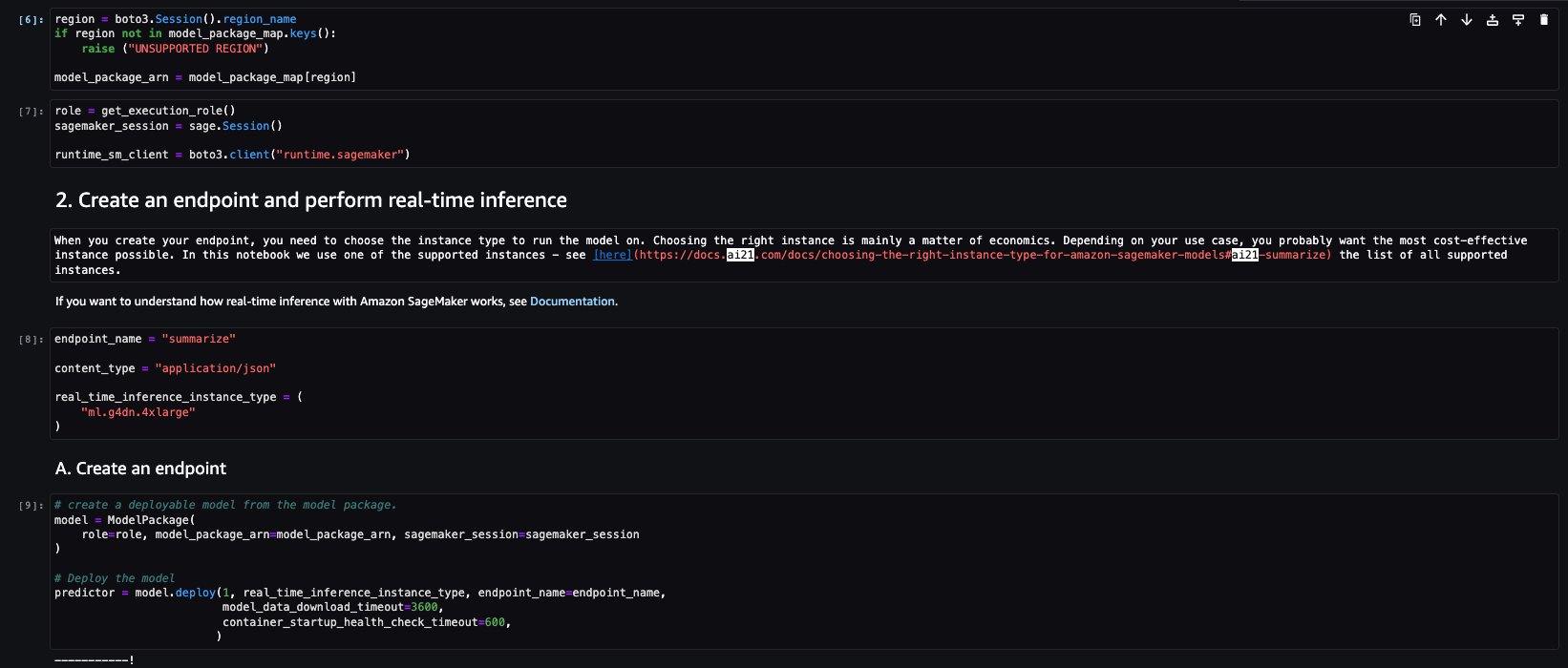

ノートブックの次の数セルでは、以下の手順を実行します:

- リージョンを選択し、モデルパッケージマップからモデルパッケージARNを取得

- 実行するモデルに対応するインスタンスタイプ(使用用途およびサポートされているインスタンスについては、Task-specific modelsを参照)を選択して、推論エンドポイントを作成

- モデルパッケージから展開可能なモデルを作成

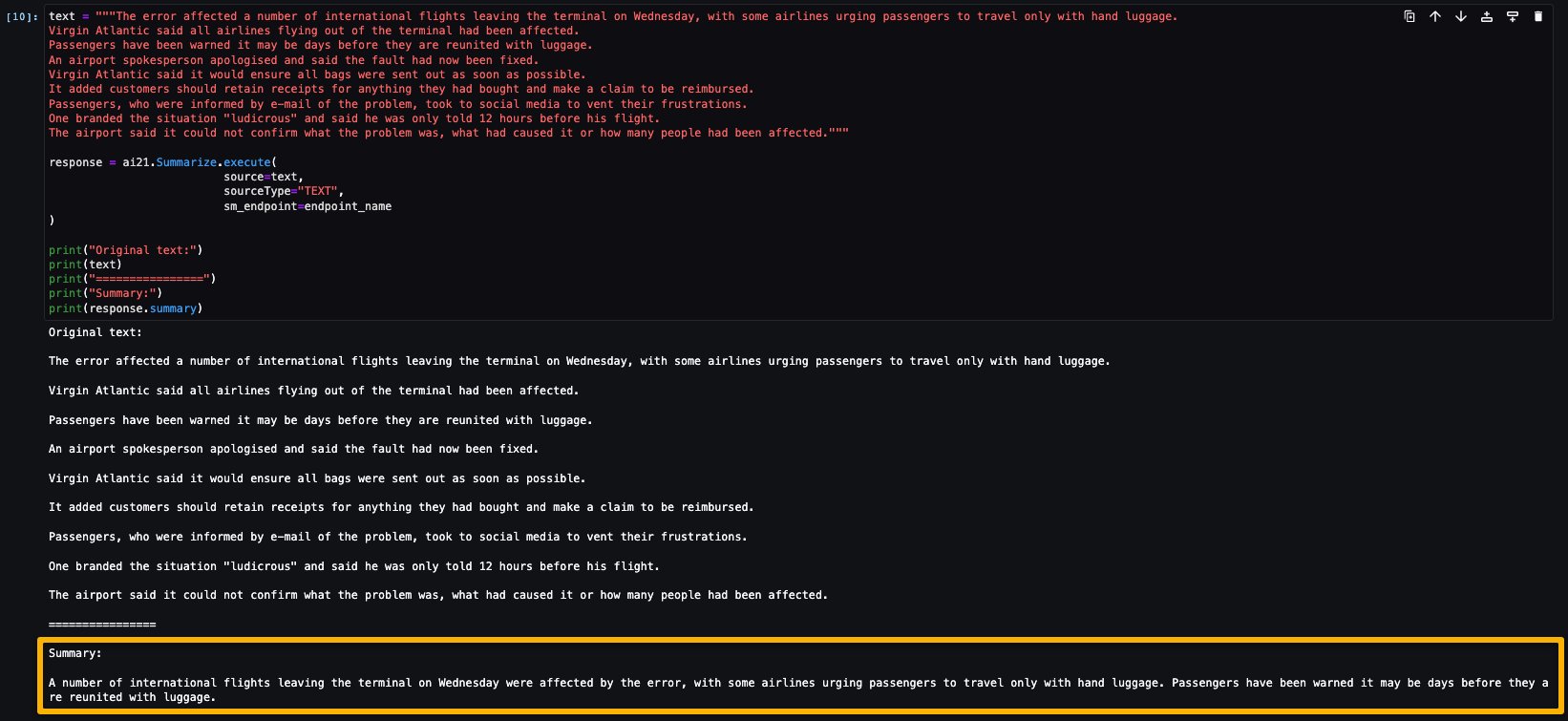

ニュース記事から取得した1つの段落の要約を生成するために推論を実行してみましょう。出力で示されているように、モデルによって要約されたテキストが出力されます。

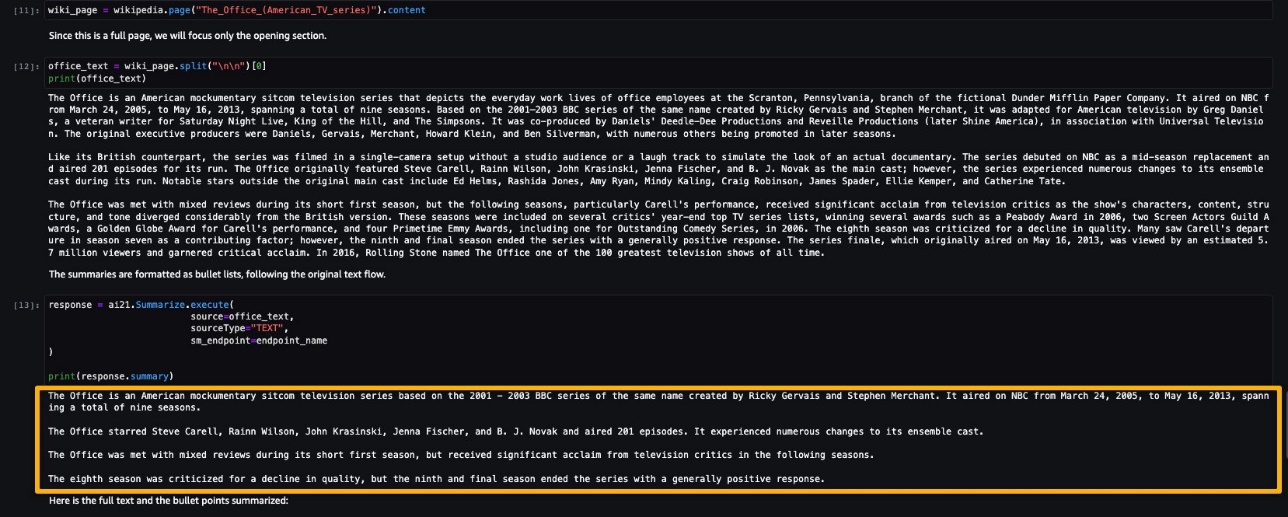

AI21 Summarizeは、50,000文字までの入力を処理できます。これは、およそ10,000語、または40ページに相当します。モデルの振る舞いのデモンストレーションとして、Wikipediaからページを読み込みます。

今回のリアルタイム推論の実行が完了したので、エンドポイントがもう必要なくなった場合は、エンドポイントを削除して請求されないようにすることができます。

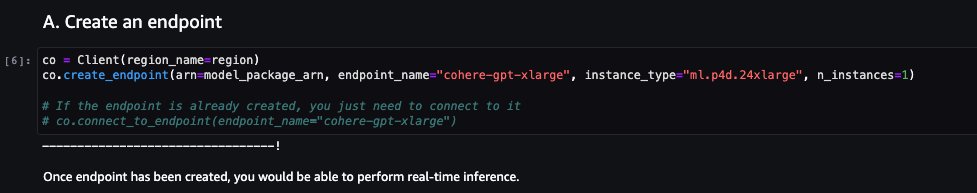

Cohere Command

Cohere Commandは、命令的なプロンプトによく反応する生成モデルです。このモデルは、すべての生成タスクにおいて最高品質、パフォーマンス、および精度を提供し、ビジネスや企業がコピーライティング、名前付きエンティティ認識、言い換え、または要約に関する取り組みを活性化して次のレベルに引き上げることができます。

Cohere Commandモデルのサンプルノートブックでは、必要な前提条件が説明されています。たとえば、モデルはAWS Marketplaceから購読され、適切なIAMロールの許可、必要なboto3バージョンなどが必要です。このノートブックでは、モデルパッケージの選択方法、リアルタイム推論のためのエンドポイントの作成方法、クリーンアップ方法などが説明されています。

一部のタスクは、以前のノートブックの例で説明されたものと似ています。たとえば、Boto3のインストール、cohere-sagemaker(Cohereモデルとのインターフェイスを簡素化するために開発された機能を提供するパッケージ)のインストール、セッションとリージョンの取得などです。

では、エンドポイントの作成を探ってみましょう。モデルパッケージのARN、エンドポイント名、使用するインスタンスタイプ、およびインスタンス数を指定します。作成後、エンドポイントはSageMakerのエンドポイントセクションに表示されます。

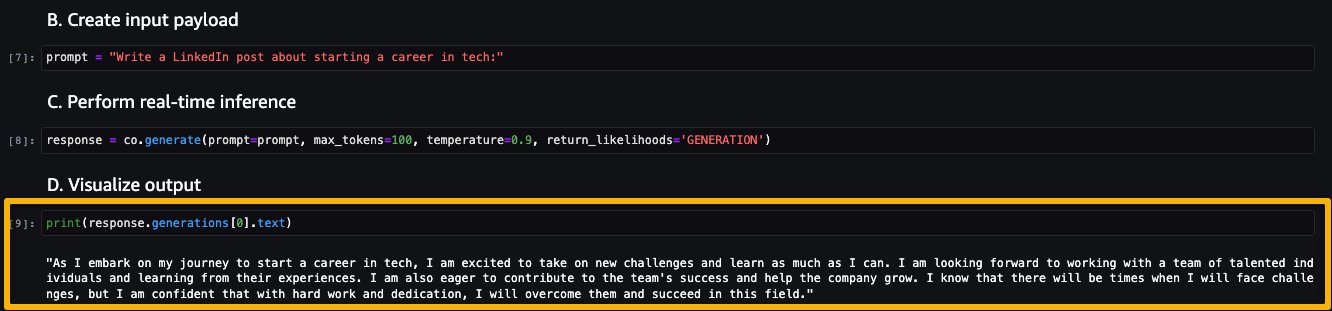

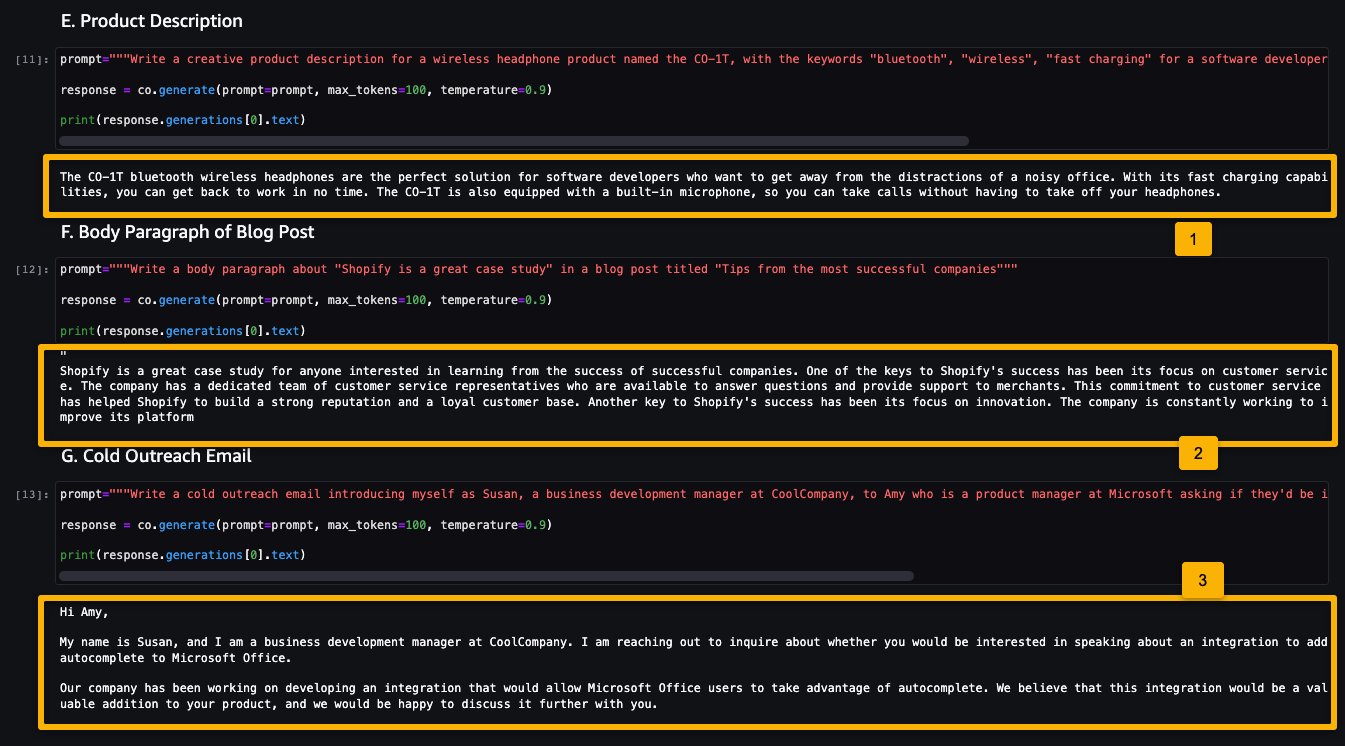

次に、推論を実行してCommandモデルからの出力を確認しましょう。

次のスクリーンショットは、ジョブポストを生成し、その出力を示したものです。モデルは与えられたプロンプトからポストを生成しました。

次に、以下の例を見てみましょう。

- 製品の説明を生成する

- ブログ投稿の本文段落を生成する

- アウトリーチメールを生成する

Cohere Commandモデルは、さまざまな生成タスクのためのテキストを生成しました。

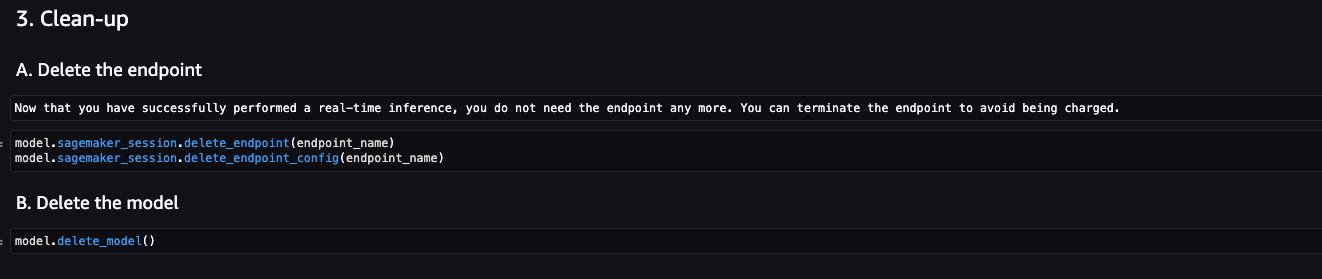

テストのためにリアルタイム推論を実行したので、エンドポイントはもう必要なくなるかもしれません。課金を回避するために、エンドポイントを削除できます。

LightOn Mini-instruct

LightOnが作成した4000億億のパラメータを持つAIモデルであるMini-instructは、高品質なデータを多数のソースから学習して構築された、強力な多言語AIシステムです。自然言語を理解し、特定のニーズに応じたコマンドに反応するように設計されています。音声アシスタント、チャットボット、スマート家電などの消費者製品においては優れた性能を発揮します。また、代理店支援や自動化された顧客ケアのための自然言語生成など、幅広いビジネスアプリケーションにも活用できます。

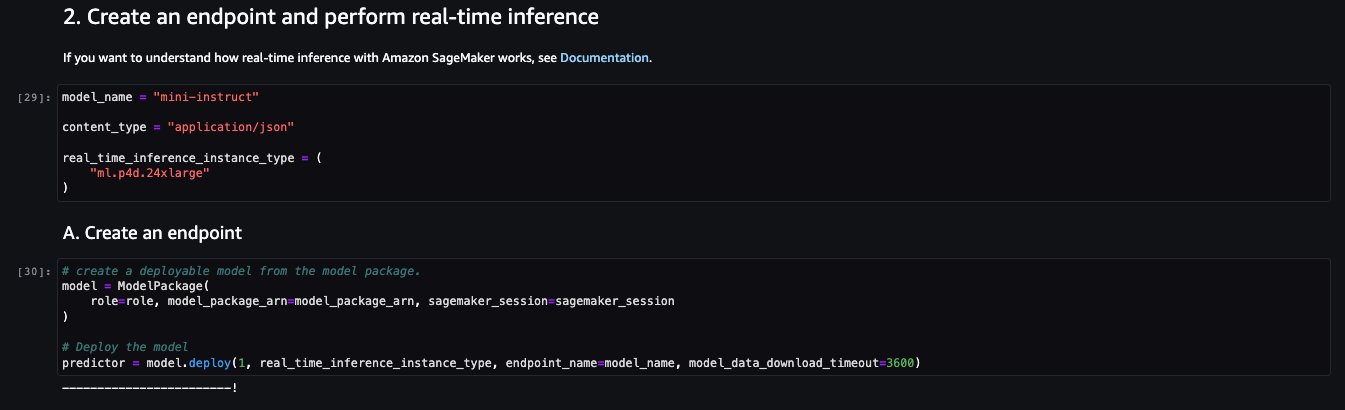

LightOn Mini-instructモデルのサンプルノートブックでは、必要な前提条件が説明されています。たとえば、モデルはAWS Marketplaceから購読され、適切なIAMロールの許可、必要なboto3バージョンなどが必要です。このノートブックでは、モデルパッケージの選択方法、リアルタイム推論のためのエンドポイントの作成方法、クリーンアップ方法などが説明されています。

一部のタスクは、以前のノートブックの例で説明されたものと似ています。たとえば、Boto3のインストール、セッションとリージョンの取得などです。

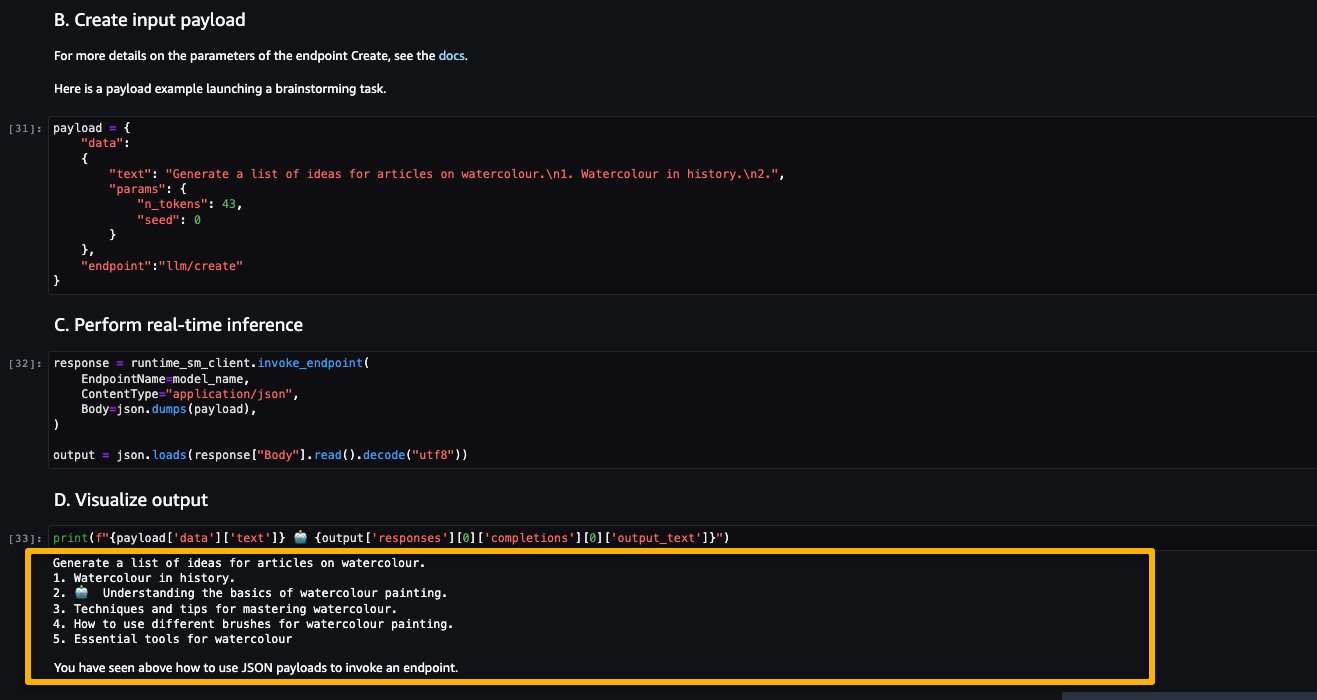

エンドポイントの作成を見てみましょう。最初に、モデルパッケージのARN、エンドポイント名、使用するインスタンスタイプ、およびインスタンス数を指定します。作成後、エンドポイントはSageMakerのエンドポイントセクションに表示されます。

今度は、トピックである水彩画に関する記事のアイデアのリストを生成するようモデルに推論させてみましょう。

ご覧のように、LightOn Mini-instructモデルは、与えられたプロンプトに基づいて生成されたテキストを提供することができました。

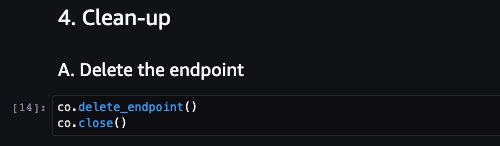

クリーンアップ

例のプロプライエタリFoundationモデルのために上記のようにモデルをテストし、エンドポイントを作成した後、SageMaker推論エンドポイントを削除し、課金を回避するためにモデルを削除してください。

結論

本ポストでは、SageMaker StudioでAI21、Cohere、LightOnなどのモデルプロバイダーからのプロプライエタリモデルの使用を開始する方法を説明しました。顧客は、SageMaker JumpStartからStudio、SageMaker SDK、SageMakerコンソールでプロプライエタリFoundationモデルを発見して使用することができます。これにより、顧客は数十億のパラメータを含み、テキストと画像のテラバイトに対して事前にトレーニングされた大規模なMLモデルにアクセスし、記事の要約、テキスト、画像、またはビデオの生成などの様々なタスクを実行できます。Foundationモデルが事前にトレーニングされているため、トレーニングとインフラストラクチャのコストを削減し、ユースケースに合わせてカスタマイズすることも可能です。

リソース

- SageMaker JumpStart documentation

- SageMaker JumpStart Foundation Models documentation

- SageMaker JumpStart product detail page

- SageMaker JumpStart model catalog

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles