データの壁を破る:ゼロショット、ワンショット、およびフューショットラーニングが機械学習を変革している

データの壁を破る:ゼロショット、ワンショット、フューショットラーニングが機械学習を変革

イントロダクション

今日の急速に変化する世界では、技術は日々向上しており、機械学習と人工知能はプロセスの自動化と効率の改善の力によってさまざまな産業を革新しています。しかし、伝統的な機械学習アルゴリズムと比べて、人間はまだ明確な優位性を持っています。なぜなら、これらのアルゴリズムは潜在的な相関に応答し、オブジェクトを識別するために何千ものサンプルが必要だからです。

- 「共通の悪いデータの10つのケースとその解決策を知る必要があります」

- 「ToolLLMをご紹介します:大規模言語モデルのAPI利用を向上させるためのデータ構築とモデルトレーニングの一般的なツールユースフレームワーク」

- 「データクリーニングと前処理の技術をマスターするための7つのステップ」

例えば、指紋や顔認識を使用してスマートフォンをアンロックする場合、アルゴリズムが機能する前に100回スキャンを行わなければならないとしたら、どれほどイライラするでしょう。このような機能は市場に出されることはありませんでした。

しかし、2005年以降、機械学習の専門家たちはゲームを完全に変えるかもしれない新しいアルゴリズムを開発してきました。過去20年近くにわたる改良により、最小数(ゼロ、ワン、少数)のサンプルから学習できるアルゴリズムが生み出されました。

この記事では、これらのアルゴリズムの背後にある概念を探求し、これらの学習技術がどのように機能し、それらを実装する際に直面するいくつかの課題についても詳しく説明します。

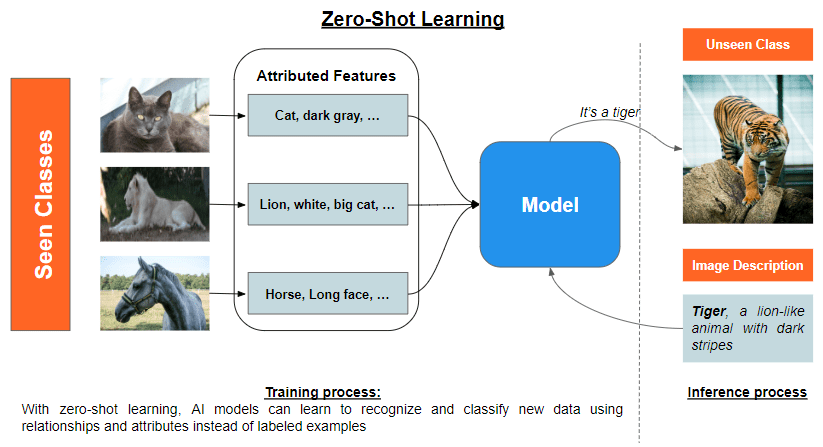

ゼロショットラーニングはどのように機能するのか?

ゼロショットラーニングは、モデルを訓練してこれまで見たことのないオブジェクトを分類するという概念です。その核となるアイデアは、他のモデルの既存の知識を利用して新しいクラスの意味のある表現を得ることです。

ゼロショットラーニングは、意味的な埋め込みまたは属性ベースの学習を使用して、既知のクラスと未知のクラスの間の関係を高いレベルで理解できるように意味のある方法で既存の知識を活用します。両方を一緒に使用することも、それぞれ単独で使用することもできます。

意味的な埋め込みは、単語、フレーズ、またはドキュメントのベクトル表現であり、それらの間の意味と関係を連続的なベクトル空間で捉えます。これらの埋め込みは通常、Word2Vec、GloVe、またはBERTなどの教師なし学習アルゴリズムを使用して生成されます。目標は、類似した意味が類似したベクトルでエンコードされるコンパクトな言語情報の表現を作成することです。このようにして、意味的な埋め込みは、テキストデータの効率的かつ正確な比較と操作、および未知のクラスに対してインスタンスを連続的な共有意味空間に投影することによる汎化を可能にします。

属性ベースの学習は、未知のクラスのラベル付きの例を使用せずにオブジェクトを分類することを可能にします。これはオブジェクトを意味のある特性に分解し、それが中間表現として機能し、既知のクラスと未知のクラスの間に対応関係を確立することができるようにします。このプロセスには通常、属性抽出、属性予測、およびラベル推論が含まれます。

- 属性抽出は、各オブジェクトクラスに対して意味のある識別属性を導出し、低レベルの特徴と高レベルの概念の間のギャップを埋めることを目指します。

- 属性予測は、インスタンスの低レベルの特徴と高レベルの属性との対応関係を学習し、特徴間のパターンと関係を認識するために機械学習の技術を使用して、新しいクラスに汎化します。

- ラベル推論は、予測された属性と未知のクラスの間の属性と関係を利用して新しいインスタンスのクラスラベルを予測することであり、ラベル付きの例に頼ることなく行われます。

ゼロショットラーニングの有望な潜在能力にもかかわらず、いくつかの課題が残っています。例えば:

- ドメイン適応: ターゲットドメインのインスタンスの分布は、ソースドメインの分布と大きく異なる場合があり、既知のクラスと未知のクラスのために学習された意味的な埋め込みの間に不一致が生じる可能性があります。このドメインのシフトは、インスタンスと属性の間に意味のある対応関係を確立できないため、パフォーマンスに悪影響を及ぼす可能性があります。この課題を克服するためには、敵対的な学習、特徴の分離、および自己教師あり学習など、さまざまなドメイン適応技術が提案されており、ソースドメインとターゲットドメインのインスタンスと属性の分布を整合させることを目指しています。

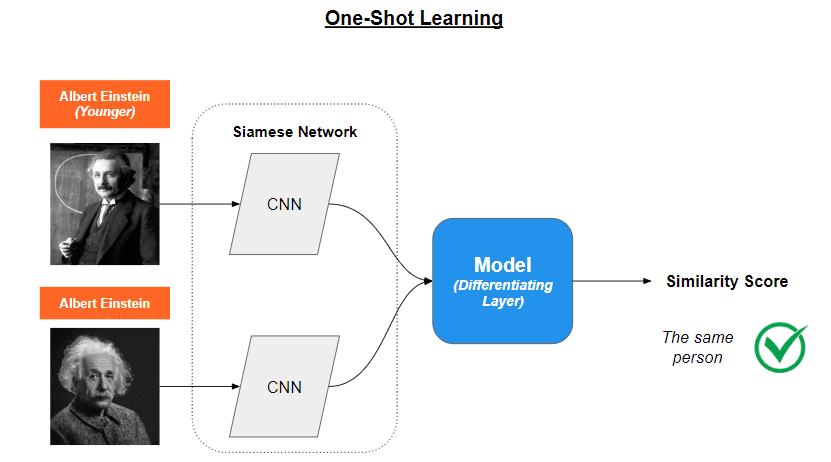

ワンショットラーニングはどのように機能するのか?

例えば、車を識別するための従来のニューラルネットワークを開発するプロセスでは、効果的に識別するためにさまざまな角度や対比の異なる数千のサンプルが必要です。 ワンショットラーニングは異なるアプローチを取ります。疑問の車を識別するのではなく、メソッドは画像Aが画像Bと同等であるかどうかを判断します。これは、モデルが以前のタスクで経験した情報を一般化することによって得られます。ワンショットラーニングは主にコンピュータビジョンで使用されます。

この目標を達成するために使用される技術には、Memory Augmented Neural Networks(MANN)およびSiamese Networksがあります。これらの技術を個別に活用することで、ワンショット学習モデルは新しいタスクに迅速に適応し、非常に限られたデータでも良いパフォーマンスを発揮することができます。これにより、ラベル付きデータを入手することが費用や時間のかかる現実のシナリオにおいても適しています。

Memory Augmented Neural Networks(MANN)は、非常に少数の例から学習するために設計された高度なニューラルネットワークの一種です。これは、人間が新しいオブジェクトのたった1つのインスタンスから学ぶことができるように、追加のメモリコンポーネントを持っています。

MANNをスマートなノートを持つロボットと考えてみてください。ロボットはノートを使って以前見たことを覚え、それを利用して新しいものを理解することができます。これにより、ロボットは通常のAIモデルよりもはるかに速く学習することができます。

Siamese Networksは、2つ以上の同一のサブネットワークを共有ウェイトで使用してデータサンプルを比較するために設計されています。これらのネットワークは、データサンプル間の重要な違いと類似点を捉えた特徴表現を学習します。

Siamese Networksを双子の探偵と考えてみてください。彼らは常に一緒に働く双子の探偵であり、同じ知識とスキルを共有しています。彼らの仕事は2つのアイテムを比較し、それらが同じか異なるかを判断することです。これらの探偵は各アイテムの重要な特徴を見て、その結果を比較して判断します。

Siameseネットワークのトレーニングは2つのステージで進行します:検証ステージと汎化ステージです。

- 検証ステージでは、ネットワークは2つの入力画像またはデータポイントが同じクラスに属するかどうかを判断します。ネットワークは双子のサブネットワークを使用してそれぞれの入力を処理します。

- 汎化ステージでは、モデルは入力データの理解を汎化し、異なるクラスを識別できる特徴表現を効果的に学習します。

2つのステージが実施された後、モデルは画像Aが画像Bに対応するかどうかを判断する能力を持ちます。

ワンショット学習は新しいクラスを検出するために再トレーニングする必要がないため、非常に有望です。ただし、高いメモリ要件や計算能力の必要性などの課題があります。学習には2倍の演算が必要です。

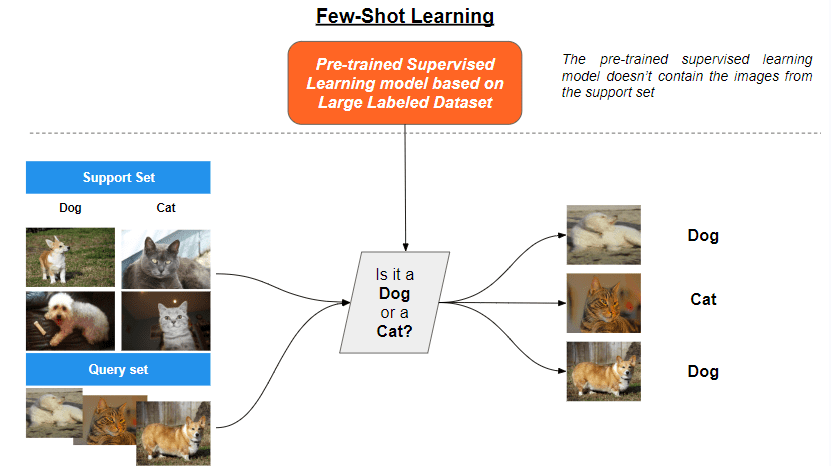

Few-Shot Learningはどのように機能するのですか?

最後に紹介される学習方法はFew-Shot Learningです。Few-Shot Learningは、わずかなラベル付きの例から学習できるアルゴリズムを開発することを目指すメタ学習のサブフィールドです。

この文脈では、Prototypical NetworksおよびModel-Agnostic Meta-Learning(MAML)は、Few-Shot Learningのシナリオで成功を収めた2つの主要な代替技術です。

Prototypical Networks

Prototypical Networksは、Few-Shot分類タスクに適したニューラルネットワークの一種です。その中心的なアイデアは、特徴空間において各クラスのプロトタイプ、または代表的な例、を学習することです。プロトタイプは、新しい入力と学習されたプロトタイプとの距離を比較することによって分類の基礎として機能します。

3つの主要なステップが含まれます:

- 埋め込み:ネットワークは、畳み込みニューラルネットワーク(CNN)や再帰型ニューラルネットワーク(RNN)などのニューラルネットワークエンコーダを使用して、各入力に対して埋め込みを計算します。埋め込みは、入力データの顕著な特徴を捉えた高次元の表現です。

- プロトタイプの計算:各クラスに対して、ネットワークはサポートセットと呼ばれる各クラスのラベル付きの例の小さなサブセットの埋め込みの平均を取ることでプロトタイプを計算します。プロトタイプは、特徴空間におけるクラスの「中心」を表します。

- 分類:新しい入力が与えられると、ネットワークはその埋め込みを計算し、入力の埋め込みとプロトタイプとの距離(例:ユークリッド距離など)を計算します。そして、入力は最も近いプロトタイプを持つクラスに割り当てられます。

学習プロセスは、プロトタイプが各クラスの埋め込みに近く、他のクラスの埋め込みから遠くなるようにする損失関数を最小化することを目指します。

モデルに依存しないメタ学習(MAML)

MAMLは、モデルのパラメータの最適な初期化を見つけることを目指すメタ学習アルゴリズムであり、数回の勾配ステップで新しいタスクに迅速に適応できるようにします。MAMLはモデルに依存しないため、勾配降下法でトレーニングされた任意のモデルに適用することができます。

MAMLには次のステップが含まれます:

- タスクのサンプリング:メタトレーニング中、タスクはタスクの分布からサンプリングされます。各タスクは、少数のラベル付きの例を持つ少数ショット学習の問題です。

- タスク固有の学習:各タスクでは、タスクのトレーニングデータ(サポートセット)を使用して、モデルのパラメータを少数の勾配ステップで微調整します。これにより、更新されたパラメータを持つタスク固有のモデルが得られます。

- メタ学習:メタ目的は、すべてのタスクのバリデーションデータ(クエリセット)におけるタスク固有の損失の合計を最小化することです。この目的を達成するために、モデルの初期パラメータが勾配降下法によって更新されます。

- メタテスト:メタトレーニング後、モデルは学習された初期化を活用して、新しいタスクに対して数回の勾配ステップで迅速に微調整することができます。

MAMLには多重のネストされた勾配更新が含まれるため、大量の計算リソースが必要です。そのため、いくつかの課題が生じます。その1つがタスクの多様性です。多くの少数ショット学習のシナリオでは、モデルは数例しかないさまざまなタスクやクラスに適応する必要があります。この多様性は、広範な微調整や適応なしで異なるタスクやクラスを効果的に処理できる単一のモデルやアプローチを開発することが困難になる可能性があります。

結論

機械学習の素晴らしい世界は、ゼロショット、ワンショット、およびフューショット学習などの画期的な技術を提供しています。これらのアプローチにより、AIモデルはわずかな例だけでオブジェクトやパターンを学習して認識することができます。これは、人間と同様の方法です。これにより、ヘルスケア、小売り、製造など、大量のラベル付きデータへのアクセスが常に簡単ではないさまざまな業界で可能性が広がります。Christophe Attenは、ファイナンスのデータサイエンティストのダイナミックなチームを率いており、2022年以降はVoAGI AI Writerでもあり、生のデータを洞察に変えることに注力しています。

オリジナル。許可を得て再投稿。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「LP-MusicCapsに会ってください:データの乏しさ問題に対処するための大規模言語モデルを使用したタグから疑似キャプション生成アプローチによる自動音楽キャプション作成」

- 「ゼロから効果的なデータ品質戦略を構築するためのステップバイステップガイド」

- 「貪欲であることはどれほど悪いのか?」

- 「マスタリングモンテカルロ:より良い機械学習モデルをシミュレーションする方法」

- データモデリング入門、パート1:データモデリングとは何ですか?

- VoAGIニュース、8月2日:ChatGPTコードインタプリタ:高速データサイエンス•追いつけない?AIの今週の話題をキャッチアップしましょう

- ユーザーフィードバック – MLモニタリングスタックの欠けている部分