複数の画像やテキストの解釈 人工知能 - Section 155

人工知能の世界とその変革の可能性を探ります

BERT 101 – 最新のNLPモデルの解説

BERTとは何ですか? BERT(Bidirectional Encoder Representations from Transformers)は、自然言語処理のための機械学習(M...

🤗 Transformersにおいて制約付きビームサーチを用いたテキスト生成のガイド

イントロダクション このブログ投稿では、トランスフォーマーを使用した言語生成のための異なるデコーディング方法について説...

Hugging Face TransformersとAWS Inferentiaを使用して、BERT推論を高速化する

ノートブック:sagemaker/18_inferentia_inference BERTとTransformersの採用はますます広がっています。Transformerベースの...

Hugging FaceでのDecision Transformersの紹介 🤗

🤗 Hugging Faceでは、ディープ強化学習の研究者や愛好家向けのエコシステムに貢献しています。最近では、Stable-Baselines3...

~自分自身を~ 繰り返さない

🤗 Transformersのデザイン哲学 「Don’t repeat yourself(同じことを繰り返さない)」、またはDRY(Don’t Repea...

Habana LabsとHugging Faceが提携し、Transformerモデルのトレーニングを加速化する

2022年4月12日、カリフォルニア州サンタクララとサンフランシスコ 深層学習によって駆動されるトランスフォーマーモデルは、...

CO2排出量と🤗ハブ:リーディング・ザ・チャージ

CO2排出量とは何であり、なぜ重要なのか? 気候変動は私たちが直面している最大の課題の一つであり、二酸化炭素(CO2)などの...

教育のためのHugging Faceをご紹介します 🤗

機械学習がソフトウェア開発の圧倒的な割合を占めること、非技術的な人々がますますAIシステムに触れることを考えると、AIの...

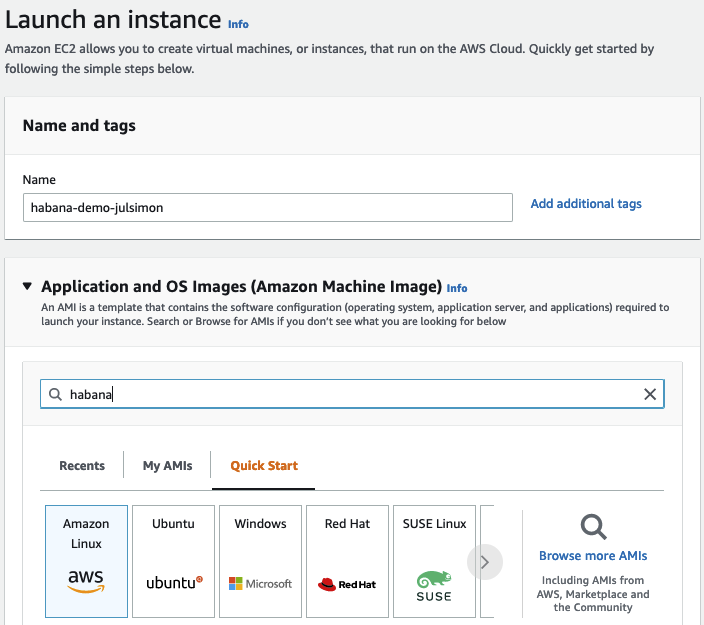

Habana GaudiでのTransformersの始め方

数週間前に、Habana LabsとHugging Faceが協力してTransformerモデルのトレーニングを加速することを発表できたことを喜んで...

KiliとHuggingFace AutoTrainを使用した意見分類

イントロダクション ユーザーのニーズを理解することは、ユーザーに関連するビジネスにおいて重要です。しかし、それには多く...

- You may be interested

- 「良い説明がすべてです」

- 「One-2-3-45++に出会ってみましょう:お...

- ETH ZurichとMax Plankの研究者が提案する...

- 「注目のAI GitHubリポジトリ:2023年11月...

- UN支援チームがウクライナの歴史的な場所...

- 2023年5月のVoAGIトップ記事:Mojo Lang:...

- 基本に戻る ウィーク4:高度なトピックと展開

- テキストの生成方法:トランスフォーマー...

- 大規模言語モデル(LLM)に関する驚くべき...

- USCの研究者は、新しい共有知識生涯学習(...

- このAI研究は、FireActを提案しますこれは...

- ディープラーニングを使用した自動音楽生成

- 「バイナリサーチアルゴリズムのデコーデ...

- 「GoogleのNotebookLMを使用したデータサ...

- 「Pythonを使用した外惑星の発見のシミュ...

Find your business way

Globalization of Business, We can all achieve our own Success.