効果的な小規模言語モデル:マイクロソフトの13億パラメータphi-1.5

Microsoft's Effective Small-scale Language Model Phi-1.5 with 1.3 Billion Parameters

既に大型言語モデル(LLM)に関するニュースを十分に聞いたと思っていたら、マイクロソフトリサーチが再び市場を騒がせてきました。2023年6月、マイクロソフトリサーチは「教科書がすべて必要だ」というタイトルの論文を発表し、コード用の新しい大型言語モデルであるphi-1を紹介しました。phi-1はトランスフォーマーベースのモデルで、13億のパラメータを持ち、8つのA100s GPUで4日間トレーニングされました。トレーニングにはウェブ上の「教科書の品質」のデータが使用されました。

LLMはますます小さくなっているようです。

- 「BlindChat」に会いましょう:フルブラウザおよびプライベートな対話型AIを開発するためのオープンソースの人工知能プロジェクト

- 「コンテキストに基づくドキュメント検索の強化:GPT-2とLlamaIndexの活用」

- 「AIはどれくらい環境に優しいのか?人間の作業と人工知能の二酸化炭素排出量を比較する」

phi-1.5とは何ですか?

ここでマイクロソフトリサーチが紹介するのはphi-1.5です。これは1.3億のパラメータを持つトランスフォーマーであり、phi-1と同じデータソースを使用してトレーニングされました。先述の通り、phi-1は高品質な教科書データでトレーニングされましたが、phi-1.5は合成データのみを使用してトレーニングされました。phi-1.5は32台のA100-40G GPUを使用し、8日間のトレーニングに成功しました。phi-1.5の目的は、LLMに関連するさまざまなセーフティ上の課題(毒性の低減、制御性の向上など)を探求するための制約のない小さなオープンソースモデルを作り出すことです。

「合成データ生成」の手法を使用することで、phi-1.5のパフォーマンスは自然言語のテストで5倍大きなモデルと同等であり、より困難な推論タスクで多くのLLMを上回ることが示されています。

非常に印象的ですね。

モデルの学習の過程は非常に興味深いものです。それは、StackOverflowからのPythonコードスニペット、合成されたPython教科書、およびGPT-3.5-turbo-0301によって生成された演習など、さまざまなソースからデータを引き出しています。

毒性とバイアスの対処

LLMには毒性や偏見のあるコンテンツとの戦いが大きな課題の一つです。マイクロソフトリサーチは、有害な/攻撃的なコンテンツや特定のイデオロギーを推進するコンテンツといった問題を克服することを目指しました。

モデルをトレーニングするために使用された合成データは、Falcon-7BやLlama 2-7Bなどの他のLLMと比較して、毒性コンテンツを生成する傾向が低い応答を生成しました。以下の画像で示されています。

ベンチマーク

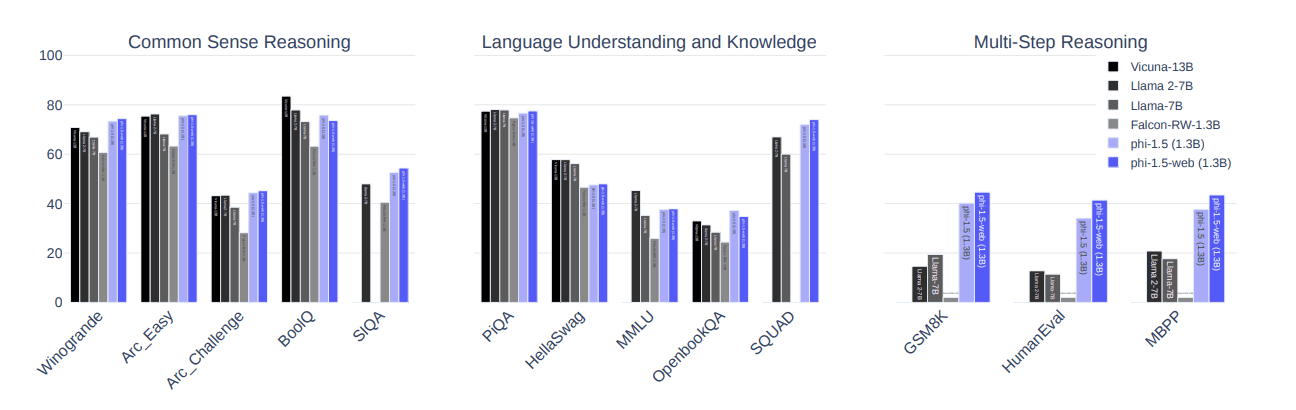

以下の画像は、phi-1.5がLlama 2-7B、Llama-7B、Falcon-RW-1.3Bなどの最新モデルよりもわずかに優れたパフォーマンスを発揮したことを示しています。ベンチマークは、常識的な推論、言語スキル、および多段階推論の3つの項目で行われました。

これはどのように行われたのでしょうか?

教科書のようなデータの使用は、インターネットから抽出されたデータと比較してLLMでのそのようなデータの使用方法を異なるものとしています。モデルがどのように毒性コンテンツに対処するかをさらに評価するために、ToxiGenも使用され、さらに86のプロンプトが設計され、手動で「パス」、「失敗」、または「理解しなかった」とラベル付けされ、モデルの制約をより良く理解するために使用されました。

上記の結果、phi-1.5は47のプロンプトに合格し、34のプロンプトに失敗し、4つのプロンプトに理解できませんでした。モデルを評価するためのHumanEvalアプローチによる応答は、phi-1.5が他のよく知られたモデルよりも高いスコアを獲得したことを示しています。

主なポイント:

次に、phi-1.5に関する重要な話題を以下にまとめます:

- トランスフォーマーベースのモデルです

- 次の単語予測を重点的にするLLMです

- 300億のトークンでトレーニングされました

- 32台のA100-40G GPUを使用しました

- 8日間のトレーニングに成功しました

Nisha Aryaは、データサイエンティスト、フリーランスの技術ライター、およびVoAGIのコミュニティマネージャーです。彼女は特にデータサイエンスのキャリアアドバイスやチュートリアル、そしてデータサイエンスに関する理論的な知識を提供することに興味を持っています。また、人工知能が/人間の寿命の延長にどのように役立つかを探求したいと考えています。彼女は積極的な学習者であり、他の人々を指導する一方で、自身の技術知識と執筆スキルを広げることを目指しています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 大規模言語モデル:RoBERTa — ロバストに最適化されたBERTアプローチ

- 「TikTokがAI生成コンテンツのためのAIラベリングツールを導入」

- デシAIは、DeciDiffusion 1.0を公開しました:820億パラメータのテキストから画像への潜在的拡散モデルで、安定した拡散と比べて3倍の速度です

- 「Hugging FaceはLLMのための新しいGitHubです」

- 「Google DeepMindが、7100万件の「ミスセンス」変異の効果を分類する新しいAIツールを発表」

- バッテリー最適化の解除:機械学習とナノスケールX線顕微鏡がリチウムバッテリーを革命化する可能性

- 機械学習リスク管理の組織プロセス