AudioPaLMの紹介:Googleの言語モデルにおける突破口

Introduction to AudioPaLM A breakthrough in Google's language model.

テック巨人Googleが、ジェネラティブAIの分野で重要な進展を遂げ、最先端のマルチモーダル言語モデルであるAudioPaLMを発表しました。この画期的なモデルは、Google I/O 2023で発表された大規模言語モデルPaLM-2と、音声生成モデルAudioLMの能力を組み合わせています。AudioPaLMは、テキストと話された言語をシームレスに統合する包括的なフレームワークを確立し、言語理解と生成の限界を押し上げます。

参考記事:Google、GPT-4 Effectに対抗するためにPaLM2を発表

マルチモーダル言語処理の力:AudioPaLM

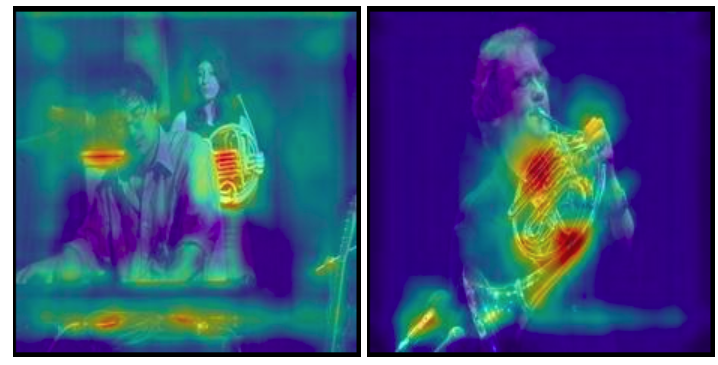

AudioPaLMは、テキストベースの言語モデルとオーディオモデルの強みを組み合わせた言語処理の大幅な進歩を表しています。音声認識や音声対音声翻訳など、広範なアプリケーションをカバーしています。AudioLMの専門知識を活用することで、音声識別や抑揚などの非言語的な手がかりをキャプチャすることができます。同時に、PaLM-2のようなテキストベースの言語モデルに埋め込まれた言語知識を統合します。このマルチモーダルアプローチにより、AudioPaLMは音声とテキストの両方を含むさまざまなタスクを処理できます。

参考記事:AIによる複数言語のYouTubeダビングが開始

- AIは精神疾患の検出に優れています

- Mojo | 新しいプログラミング言語

- PyRCAをご紹介します:AIOpsにおけるRoot Cause Analysis(RCA)のために設計されたオープンソースのPython Machine Learningライブラリです

音声とテキストのための統合アーキテクチャ:AudioPaLMフレームワーク

AudioPaLMの核心には、強力な大規模トランスフォーマーモデルがあります。既存のテキストベースの言語モデルをベースに、AudioPaLMは専門の音声トークンで語彙を拡張します。音声とテキストのタスクを処理できる単一のデコーダモデルをトレーニングすることで、AudioPaLMは従来は分離されていたモデルを統合アーキテクチャに統合します。このアプローチにより、モデルは音声認識、テキストから音声の合成、音声対音声翻訳などのタスクで優れたパフォーマンスを発揮し、マルチモーダル言語処理の多目的なソリューションを提供します。

AudioPaLMの印象的なパフォーマンスと多様性

AudioPaLMは、音声翻訳のベンチマークで優れたパフォーマンスを発揮し、正確で信頼性の高い翻訳を提供する能力を示しています。さらに、音声認識のタスクでも競争力のある結果を提供し、話された言語を正確にテキストに変換します。AudioPaLMは、元の言語でトランスクリプトを生成したり、翻訳を提供したり、入力テキストに基づいて音声を生成したりすることができます。この多様性により、AudioPaLMはテキストと音声コミュニケーションのギャップを埋める強力なツールとなります。

Googleによる音声生成の持続的なイノベーション

AudioPaLMは、Googleの初めての音声生成ではありません。今年早く、彼らは高品質の音楽を生成する高精度な音楽生成モデルであるMusicLMを導入しました。AudioLMの基盤に構築されたMusicLMは、階層的なシーケンスツーシーケンスのアプローチを利用して高品質の音楽を生成します。また、Googleはテキストから音楽を生成するためのキュレーションされたデータセットであるMusicCapsを導入しました。

参考記事:次世代音声ソリューションでビジネスを強化するトップ5 AI音声ジェネレーター

音声生成領域における競争

Googleの競合他社も、音声生成分野で重要な進展を遂げています。Microsoftは最近、音声とテキストの両方のタスクで優れたパフォーマンスを発揮するオーディオ言語モデルであるPengiを発表しました。音声とテキストの入力を統合することで、Pengiは追加のファインチューニングなしで自由形式のテキスト出力を生成できます。同様に、Mark Zuckerbergが率いるMetaは、既存のメロディに合わせて音楽を作成するトランスフォーマーベースのモデルであるMusicGenを導入しました。Metaの多言語生成AIモデルであるVoiceboxは、コンテキスト学習を通じてさまざまな音声生成タスクを実行する能力を示しています。

参考記事:GoogleのオーディオモデルSoundStormが音声生成界を席巻

私たちの意見

GoogleがAudioPaLMを発表したことは、言語モデルの発展における別のマイルストーンを示しています。テキストと音声をシームレスに統合することで、AudioPaLMは音声認識から翻訳までさまざまなアプリケーションに強力なツールを提供します。ジェネラティブAIが進化し続ける中、これらのマルチモーダル言語モデルは前例のない能力を提供し、テキストと音声がシームレスに相互作用する未来に近づくことを可能にします。

画像の出典:cloudbooklet

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles