「Google CloudとNVIDIAが協力を更に進展させる」

Google Cloud and NVIDIA further advance collaboration

生成AIと大規模言語モデル(LLMs)が革新を推進する中で、トレーニングと推論のためのコンピューティング要件は驚異的なペースで増え続けています。

そのニーズに応えるため、Google Cloudは本日、NVIDIA H100 Tensor Core GPUを搭載した新しいA3インスタンスの一般提供を発表しました。これらのGPUは、Transformer Engineによる前例のないパフォーマンスをもたらし、LLMsを加速するように特別に設計されたAIアプリケーションに対応しています。

A3インスタンスの提供は、NVIDIAがGoogle Cloudの生成AIパートナー・オブ・ザ・イヤーに選ばれた直後に行われました。この賞は、両社の深いかつ継続的な協力を認めるものであり、Google Cloud上での生成AIの加速に向けた取り組みを評価しています。

この共同の取り組みは、インフラ設計から広範なソフトウェアの有効化まで、Google Cloudプラットフォーム上でのAIアプリケーションの構築と展開を容易にするためのものです。

Google Cloud Nextカンファレンスでは、NVIDIAの創設者兼CEOであるJensen Huangが、Google CloudのCEOであるThomas Kurianとともにイベントの基調講演を行い、NVIDIA H100 GPUを搭載したA3インスタンスの一般提供を祝い、GoogleがDeepMindやその他の部門で内部研究と推論にNVIDIA H100およびA100 GPUを使用していることについて語りました。

議論の中で、Huangは、PaxMLフレームワークのためのNVIDIA GPUアクセラレーションを可能にしたより深いレベルの協力に言及しました。このJaxベースの機械学習フレームワークは、大規模なモデルのトレーニングを目的としており、高度かつ完全に構成可能な実験と並列化を可能にします。

PaxMLは、GoogleがDeepMindや研究プロジェクトなどの内部モデルを構築するために使用され、NVIDIA GPUを使用します。さらに、両社はPaxMLがNVIDIA NGCコンテナレジストリで即座に利用可能であることを発表しました。

生成AIのスタートアップが豊富に存在

現在、NVIDIAの技術を使用しているGoogle Cloud上で、1000以上の生成AIのスタートアップが次世代のアプリケーションを開発しています。その中には、WriterやRunwayなどがあります。

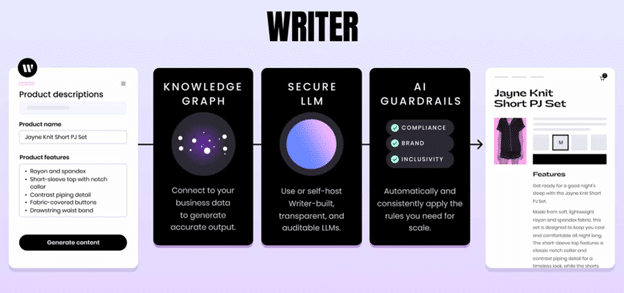

Writerは、トランスフォーマーベースのLLMsを使用して、マーケティングチームがウェブページ、ブログ、広告などのコピーを素早く作成できるようにします。そのために、同社はNVIDIA AI EnterpriseのアプリケーションフレームワークであるNeMoを活用し、トレーニングデータセットをキュレーションし、LLMsを構築・カスタマイズし、それらを本番環境でスケールさせることができます。

NeMoの最適化を使用することで、Writerの開発者は数億パラメータのモデルから400億パラメータのモデルで作業できるようになりました。このスタートアップの顧客リストには、Deloitte、L’Oreal、Intuit、Uberなどの一流企業が含まれています。

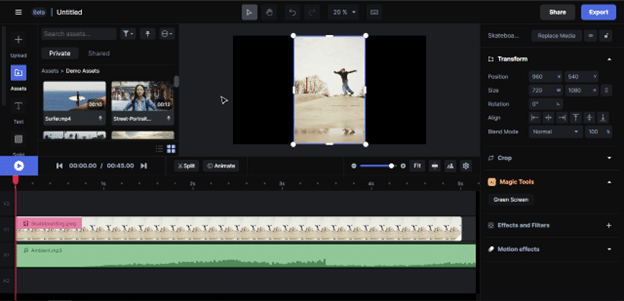

Runwayは、AIを使用して任意のスタイルのビデオを生成します。AIモデルは、与えられた画像やテキストプロンプトによって指示された特定のスタイルを模倣します。ユーザーはまた、既存の映像素材を使用して新しいビデオコンテンツを作成するためにモデルを使用することもできます。この柔軟性により、映画製作者やコンテンツクリエーターは、まったく新しい方法でビデオを探求しデザインすることができます。

Google Cloudは、NVIDIA L4 GPUをクラウドに導入した最初のCSPでした。さらに、両社はGoogleのDataprocサービスがRAPIDS Accelerator for Apache Sparkを活用し、ETLのパフォーマンスを大幅に向上させるための協力を行っており、DataprocはGoogle Compute Engineで利用可能であり、Serverless Dataprocでも近日中に利用可能になります。

両社はまた、NVIDIA AI EnterpriseをGoogle Cloud Marketplaceで利用可能にし、NVIDIAのアクセラレーションソフトウェアをVertex AI開発環境に統合しました。

Google Cloud上でのNVIDIA GPUインスタンスの詳細や、NVIDIAが生成AIを支える方法、および組織がGPUアクセラレートされたGoogle Cloud上でミッションクリティカルなエンタープライズアプリケーションを実行している方法についての詳細は、以下のリンクをご覧ください。

最新のブレークスルー、開発、技術について最新情報を入手するために、生成AIニュースにサインアップしてください。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles